Pressionado pela crise das notícias falsas, o Google reagiu com mudanças em sua joia da coroa, os algoritmos de busca: a partir desta semana darão mais peso às páginas consideradas mais confiáveis e tornarão menos visíveis os conteúdos de baixa credibilidade.

Depois de meses de testes, as melhorias anunciadas pretendem evitar que os primeiros lugares das buscas continuem exibindo páginas que negam o Holocausto, divulgam mensagens vergonhosas contra as mulheres ou difundem boatos como o de que Barack Obama prepara um golpe de Estado contra Donald Trump.[ad name=”Retangulo – Anuncios – Duplo”]

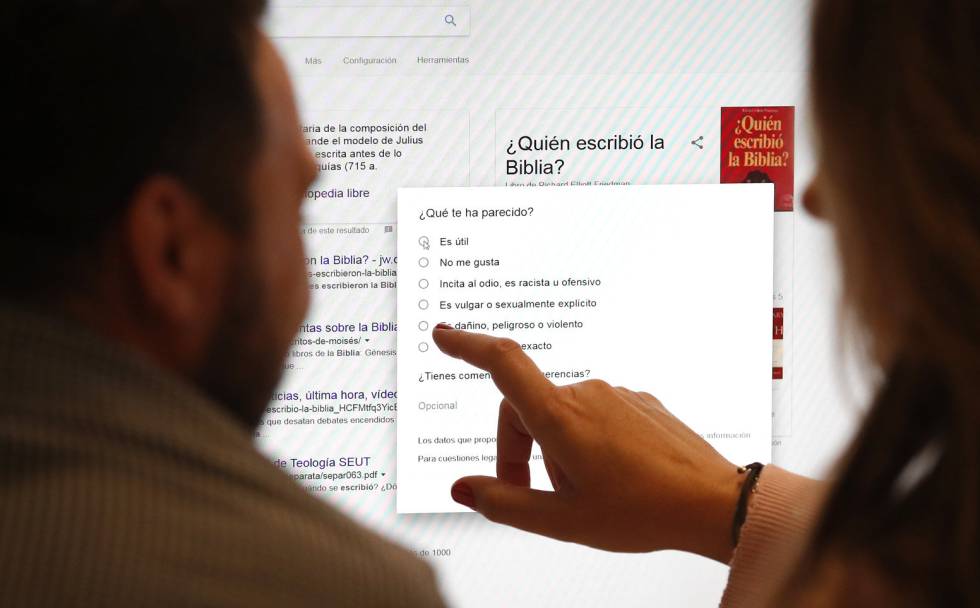

Com o mesmo objetivo, o Facebook começa a permitir aos usuários que denunciem informações duvidosas. A partir desta semana, também passa a mostrar abaixo delas notícias confiáveis sobre o mesmo tema e também links para sites de checagem de dados.

A divulgação de mentiras, informações muito tendenciosas, rumores e boatos foi protagonista nas campanhas do Brexit e das eleições presidenciais nos EUA e colocou sob escrutínio os algoritmos de Google e Facebook, acusados de favorecer a divulgação de notícias falsas e a criação de bolhas ideológicas.

Isso porque as redes sociais mostram na timeline de cada usuário o que seus algoritmos intuem que a pessoa vai gostar, favorecendo notícias que confirmam sua visão de mundo diante das que questionam suas ideias, segundo adverte o relatório do projeto REIsearch, patrocinado pelo Atomium (o Instituto Europeu para a Ciência, Meios de Comunicação e Democracia), que acaba de lançar uma grande pesquisa pública para questionar os europeus sobre este e outros impactos da nova geração de tecnologias da Internet.

“Culpar as redes sociais pelas bolhas ideológicas é um paradoxo. Ampliam a visão dos usuários para além de seu entorno mais próximo, mas não resolveram um problema que já existia, porque seus algoritmos ainda não são suficientemente bons”, afirma David García, pesquisador da área de ciências sociais computacionais na Escola Politécnica Federal de Zurique.

Ali ele analisa se o conteúdo emocional das notícias falsas contribuiu para aumentar sua difusão. E destaca que os algoritmos podem detectá-las melhor se forem alimentados com dados sobre como são compartilhadas as notícias nas redes sociais.

Monitorar os usuários

“A pesquisa sobre as redes sociais permite identificar os usuários que compartilham notícias não verazes. Um algoritmo poderia detectar que uma notícia está sendo compartilhada por muitos desses usuários e classificá-la como possivelmente falsa”, afirma David García. “Imagino que o Google esteja fazendo algo parecido para melhorar seu algoritmo, mas o problema é que não sabemos o que é.”

Em 2015, um grupo de cientistas do Google publicou um artigo de pesquisa no qual explicava um novo método para avaliar a qualidade dos sites em função da veracidade dos dados que contém, em vez do método tradicional do buscador, que determina a popularidade de um site combinando uma multiplicidade de sinais externos, como o número de links para ele a partir de outros sites.

O Google não esclarece se incorporou esse algoritmo da verdade em suas melhorias recentes.

Walter Quattrociocchi, pesquisador da área de ciência de dados, redes e algoritmos no IMT – Institute for Advanced Studies italiano, alerta sobre essa ideia: “Um algoritmo, por definição, nunca será capaz de distinguir o verdadeiro do falso”.

Carlos Castillo, que dirige o grupo de pesquisas de ciência de dados no Eurecat (Barcelona), concorda: “Decidir se algo é verdadeiro ou falso não é algo que devemos terceirizar para uma máquina. Nem para outras pessoas. Não pode haver um Ministério da Verdade [como o do romance 1984, de George Orwell], tampouco um algoritmo da verdade”.

Pelo contrário, o pesquisador afirma que a maioria das mudanças anunciadas por Google e Facebook nas últimas semanas aplicam soluções baseadas na participação humana. Castillo defende o fomento do ceticismo visível: destacar as notícias falsas e contextualizá-las, ao contrário das exigências de que Facebook e Google as eliminem.

Soluções humanas: educação e verificação de dados

“O que sim podemos pedir a um algoritmo é que nos ajude a avaliar a veracidade de uma informação, destacando os dados e demais elementos que devemos comparar para formar nossa opinião”, acrescenta o pesquisador Carlos Castillo.

“Decidir se algo é verdadeiro ou falso não é algo que devemos terceirizar para uma máquina. Nem sequer para outras pessoas.”

Assim, a Full Fact, uma agência independente de verificação de dados, prevê que este ano seus revisores possam começar a usar inteligência artificial para agilizar seu trabalho.

Google e Facebook começaram a dar visibilidade a estas verificações humanas ao lado das notícias que divulgam, para que os usuários possam avaliar melhor sua veracidade.

Walter Quattrociocchi destaca a necessidade de “sinergias entre jornalistas e instituições acadêmicas para promover um intercâmbio cultural e combater a difusão de notícias falsas”.

“O problema não será resolvido pelos algoritmos”, adverte David García. E Carlos Castillo concorda também que “nos falta alfabetização midiática: ainda não desenvolvemos certas habilidades para avaliar as notícias, mas faremos isso”.

Na mesma linha, Andreas Schleicher, diretor de Educação da OCDE (Organização para a Cooperação e o Desenvolvimento Econômico) anunciou que a análise crítica de informações digitais será incorporada ao próximo relatório PISA, que em 2018 avaliará o rendimento acadêmico dos estudantes de nível secundário internacionalmente.

ElPais